KimiK2Thinking模型发布并开源,全面提升Agent和推理能力

发布时间:2026-02-03 05:21来源:投资界阅读量:5572

近日,月之暗面发布Kimi K2 Thinking—— Kimi 迄今能力最强的开源思考模型。

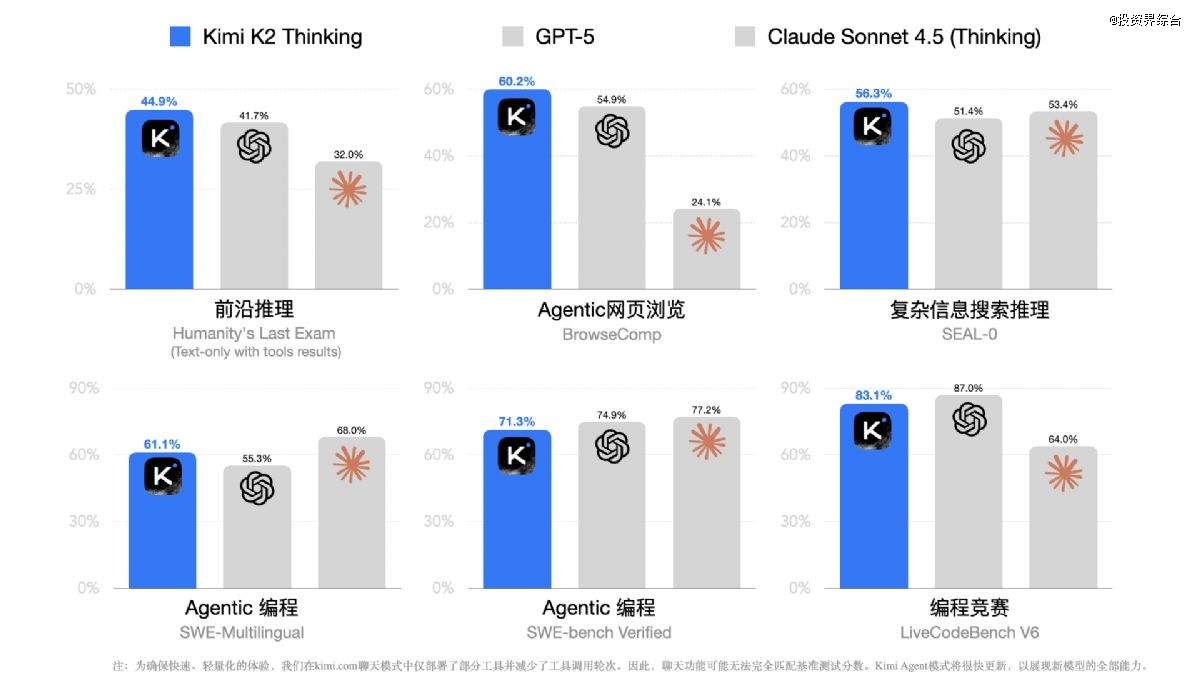

Kimi K2 Thinking 是基于「模型即 Agent」理念训练的新一代Thinking Agent,它原生掌握「边思考,边使用工具」的能力。在人类最后的考试、自主网络浏览能力(BrowseComp)、复杂信息收集推理(SEAL-0)等多项基准测试中表现达到 SOTA 水平,并在 Agentic 搜索、Agentic 编程、写作和综合推理能力等方面取得全面提升。

Kimi K2 Thinking 模型无需人类干预,即可自主实现高达 300 轮的工具调用和持续稳定的多轮思考能力,从而帮助用户解决更复杂的问题。这是在 Test-Time Scaling领域的最新进展,通过同时扩展思考 Token 和工具调用的轮次,实现更强的 Agent 和推理性能。

Kimi K2 Thinking 模型的 API 可通过 Kimi 开放平台访问。如需自行部署,请在Hugging Face、ModelScope等平台下载模型。

推理性能全面提升

Kimi K2 Thinking 模型在人类最后的考试中展现出强大的推理与问题解决能力。人类最后的考试是一项涵盖 100 多个专业领域的*封闭式学术测试。在允许使用工具——搜索、Python、网络浏览工具的同等情况下,Kimi K2 Thinking 在这项基准评测中取得了 44.9% 的 SOTA 成绩。

来看一个人类最后的考试中人文类题目推理过程示例。在这个示例中,Kimi K2 Thinking 经过 5 轮搜索和推理,结合每轮搜索到的新信息,层层深入,最终推理出了答案:

完整推理过程

自主搜索与浏览能力全面提升

在复杂搜索和浏览场景中,Kimi K2 Thinking 模型也表现出色。BrowseComp 是由 OpenAI 发布的一个专门评估 AI Agent 网络浏览能力的基准测试,这项测试的初衷是衡量 AI Agent 在信息过载环境中展现出的坚持性与创造力,即能否像人类研究员一样「刨根问底」。在这项*挑战的任务上,人类平均只能达到 29.2% 的成绩。Kimi K2 Thinking 在这项基准测试中展现出极强的钻研能力,以 60.2% 的成绩成为新的 SOTA 模型。

在长程规划和自主搜索能力的驱动下,Kimi K2 Thinking 可借助多达上百轮的“思考 搜索 浏览网页 思考 编程”动态循环,持续地提出并完善假设、验证证据、进行推理,并构建出逻辑一致的答案。这种边主动搜索边持续思考的能力,使 Kimi K2 Thinking 能够将模糊且开放式的问题分解为清晰、可执行的子任务。

完整推理过程

Agentic 编程能力持续精进

Kimi K2 Thinking 模型的编码能力也得到了增强,在多语言软件工程基准 SWE-Multilingual、SWE-bench 验证集和 Terminal 终端使用等基准测试中的表现有了进一步提升。

观察到 Kimi K2 Thinking 在处理 HTML、React 以及组件丰富的前端任务时性能有明显提升,能将创意转变为功能齐全、响应式的产品。在 Agentic Coding 场景中,Kimi K2 Thinking 能在调用各种工具的同时进行思考,灵活地融入 software agents 中,处理更复杂、多步骤的开发工作流。

来看两个例子:

现在,Kimi K2 Thinking 可以帮你复刻一个真实可用的 Word 文字编辑器。

Kimi K2 Thinking 也可以帮你创造一个华丽风格的体素艺术作品:

通用基础能力升级

创意写作:Kimi K2 Thinking 显著提升了写作能力,它能将粗略的灵感转化为清晰、动人且意图明确的叙述,使其兼具韵律感和深度。它能轻松驾驭微妙的文风差异和模糊的结构,并在长篇大论中保持风格的连贯性。在创意写作方面,它笔下的意象更生动,情感共鸣更强烈,将精准的表达与丰富的表现力融为一体。

学术与研究:在学术研究和专业领域,Kimi K2 Thinking 在分析深度、信息准确性和逻辑结构方面均有显著提升。它能有条不紊地剖析复杂的指令,并以清晰严谨的方式拓展思路。这使其尤其擅长处理学术论文、技术摘要,以及那些对信息完整性和推理质量要求极高的长篇报告。

个人与情感:在回应个人或情感类问题时,Kimi K2 Thinking 的回答更富同理心,立场也更中正平和。它的思考深入周到且具体明确,能提供细致入微的观点和切实可行的后续建议。它能清晰并关切地帮助用户梳理复杂的决策,其语气既脚踏实地又切实中肯,更有人情味。

来看一个辅助阅读英文技术论文的例子:

完整分析过程

原生 INT4 量化提升推理效率

低比特量化是降低大规模推理服务器的延迟和 GPU 显存占用的有效方法。测试发现,因为思考模型会产生极长的解码长度,常规的量化手段往往会导致模型性能大幅下降。为了克服这一挑战,在后训练阶段采用了量化感知训练(QAT),并对 MoE 组件应用了 INT4 纯权重(weight-only)量化。

这使得 Kimi K2 Thinking 模型能够在复杂推理和 Agentic 任务中支持原生的 INT4 推理,并将生成速度提升了约 2 倍。INT4 对推理硬件的兼容性更强,对国产加速计算芯片也更加友好。值得注意的是,所有的基准测试成绩都是在 INT4 精度下取得的。

现在开始使用

Kimi K2 Thinking 模型 API 已上架 Kimi 开放平台,支持 256K 上下文,价格与 Kimi K2-0905 相同,每百万 Token 输入 4 元,输出 16 元,命中缓存的输入为 1 元。速度高达 100 Token/s 的 Turbo API 也同步上架,每百万Token输入 8 元,输出 58 元,命中缓存的输入为 1 元。欢迎开发者测试反馈新模型 API,入门指南请参考此文档。

更多模型性能评估数据和使用案例,可参考这篇技术博客。

关于 Kimi K2 模型Kimi K2 模型最初发布于 7 月 11 日,它是一款混合专家架构的开源基础模型,总参数 10,000 亿,激活参数 320 亿。9 月 5 日,Kimi K2-0905 版更新,进一步提升了代码能力,并且将上下文窗口从 128K 升级到 256K。截止目前,包括 Cline、Cursor、flowith、Genspark、Kilo Code、Kortix Suna、OpenRouter、Perplexity、RooCode、TRAE、Trickle、Vercel、Windsurf 、YouWare 等在内的产品都接入或在使用 Kimi K2 模型。11 月 6 日,Kimi K2 Thinking 模型发布,全面提升 Agent 和推理能力。

声明:免责声明:此文内容为本网站转载企业宣传资讯,仅代表作者个人观点,与本网无关。仅供读者参考,并请自行核实相关内容。

热门阅读

-

TrendForce集邦:AI服务器需求刺激,HB

,AI服务器出货动能强劲带动HBM需求提升,据TrendForce集邦咨询研究显示,2022年三大原厂HBM市占率分别为SK海力士50%、三星(Samsung)约40%、美光(Micron)约10%。...

2023-04-19 09:55 -

Netflix第一季度营收81.62亿美元同比增长

北京时间4月19日早间消息,美国视频流媒体服务提供商Netflix今日公布了该公司的2023财年第一季度财报。报告显示,Netflix第一季度营收为81.62亿美元,与上年同期的78.68亿美元相比增...

2023-04-19 08:56